Tous droits réservés pour tous pays. All rights reserved.

| Serveur © IRCAM - CENTRE POMPIDOU 1996-2005. Tous droits réservés pour tous pays. All rights reserved. |

Rapport Ircam 23/79, 1979

Copyright © Ircam - Centre Georges-Pompidou 1979

Or les techniques de codage numérique permettent dans certaines conditions de protéger les signaux contre le bruit et la distorsion. On peut représenter les sons sous forme de nombres codés -- cette représentation, qui permet la synthèse des sons par ordinateur, se présente aussi à l'enregistrement numérique des sons. Aussi avons-nous proposé en janvier 1975 que l'IRCAM étudie les possibilités musicales de l'archivage numérique des sons, c'est-à-dire de l'enregistrement et de la conservation des sons sous forme de nombres codés. Cette étude a été financée dans le cadre de l'enveloppe recherche sur les exercices 1976 et 1977.

La recherche proposée visait d'abord à mettre en oeuvre un système d'enregistrement et d'archivage numérique des sons, mais aussi à préciser les spécifications minimales nécessaires pour assurer une haute qualité musicale, et enfin à étudier des méthodes pouvant permettre une économie de codage.

Ce rapport final expose les travaux effectués. Il décrit d'abord le système d'enregistrement numérique mis en place à l'IRCAM et ses performances, qui dépassent les possibilités de l'enregistrement analogique. Chemin faisant il spécifie les spécifications minimales qui ont été jugées nécessaires, et il précise les procédés qui ont permis d'atteindre ces spécifications dans la réalisation de l'IRCAM (réalisation qui va être commercialisée sous licence IRCAM). Puis il expose une nouvelle méthode de codage étudiée dans le cadre du projet et qui permet une économie appréciable de données. Il conclut sur une discussion des possibilités pratiques, des problèmes et des perspectives de l'enregistrement et de l'archivage numérique, qu'il s'agisse de la réalisation IRCAM ou de diverses réalisations industrielles qui ont vu le jour a peu près simultanément.

Ce rapport final peut paraître tardif pour un projet budgétairement terminé comme prévu le 31 décembre 1977 : comme il avait été précisé lors des Comités de Recherche des 21 avril et 18 mai 1977 (cf. le procès-verbal), l'IRCAM a souhaité ne « boucler » le projet qu'une fois les tests effectués dans le nouveau bâtiment IRCAM, en utilisant les circuits définitifs et les studios d'enregistrement. L'ordinateur a été transféré dans le nouveau bâtiment IRCAM en octobre 1977 ; la mise en oeuvre des studios est intervenue plus tard que prévu ainsi que celle des circuits définitifs. Nous avons pu mesurer les performances du système, et en particulier les produits de distorsion, réduits à moins de 90 dB au-dessous du niveau du signal (cette performance mesurée entre entrée analogique et sortie analogique après passage par le système d'archivage).

L'auteur de ce rapport, responsable du projet D.G.R.S.T. sur l'archivage numérique des sons, insiste sur le travail

scientifique et technique accompli principalement par David Cockerell et Andy Moorer durant leur séjour à l'IRCAM,

ainsi que par Tim Orr, Design Consultant, et aussi par divers collaborateurs de l'IRCAM, principalement Max Mathews,

James Lawson, Peter Eastty, Jean-Louis Richer, Didier Roncin, et également Brian Harvey, Raymond Bara.

Le théorème d'échantillonnage (appelé souvent théorème de Shannon, mais établi antérieurement sous d'autres

formes par Kupfmuller, Nyquist, Whittaker (1918), voire Cauchy) indique que toute onde de bande passante limitée à f Hz est parfaitement définie par (et peut être reconstituée à partir de) la donnée d'au moins 2f échantillons par

seconde. La reconstitution peut se faire par une interpolation en sin x/x qui peut être approchée de façon satisfaisante

par un filtrage passe-bas. Pour l'enregistrement de la musique, la bande passante devrait être d'au moins 15.000 Hz,

ce qui suppose donc environ 40.000 échantillons par seconde et par canal (4 fois plus en quadraphonie). D'autre part

les échantillons doivent être codés avec une précision suffisante pour maintenir le bruit (ou la distorsion) de

quantification à une valeur subliminale. On sait réaliser des convertisseurs analogique-numérique (ou

analogique-digital-ADC) (qui échantillonnent un signal analogique électrique) et numérique-analogique (ou

digital-analogique-DAC) (qui restituent une tension électrique à partir d'échantillons) avec une précision supérieure à

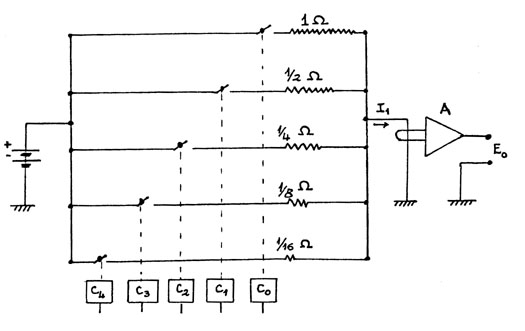

12 bits. (Ainsi les DACs comportent un réseau de résistances et de commutateurs électroniques -- transistors

permettant d'engendrer un signal analogique d'entrée comme somme pondérée de signaux individuels correspondant

aux divers bits, cette somme étant déterminée par le signal numérique d'entrée -- cf. Fig. 1.).

Cependant il est difficile de concilier rapidité (taux d'échantillonnage élevé) et précision comme il sera exposé

ci-dessous : il est difficile de construire des réseaux rapides et précis, et il est difficile de les mettre sous forme

de circuits intégrés, l'intégration se prêtant mieux à la réalisation d'opérations approximatives rapides sur les

amplitudes qu'à l'obtention d'une grande précision sur ces amplitudes. Par ailleurs on manque de données sur la

précision réellement nécessaire pour assurer une bonne qualité musicale.

Les échantillons doivent être stockés sur une mémoire de masse de capacité suffisante -- disque magnétique ou

bande magnétique. Si le disque magnétique présente certains avantages de fonctionnement, la bande magnétique est

actuellement préférable pour l'archivage, étant moins coûteuse et moins encombrante. Le système de conversion doit

permettre de prélever ou de restituer les échantillons à un rythme rigoureusement constant : cela impose

l'usage d'une mémoire-tampon (buffering) pour découpler ce rythme (sous contrôle d'une horloge externe définissant

avec précision la fréquence d'échantillonnage) de la cadence irrégulière d'accès à la mémoire de masse (rotation

physiquement irrégulière occasionnant pleurage et scintillation, voire interruptions du débit dues au groupement

d'échantillons en blocs séparés).

L'ordinateur DEC 10 a été choisi pour servir les besoins des divers départements de l'IRCAM dans le domaine de la

recherche musicale -- en particulier dans le domaine du traitement du son. Cet ordinateur est utilisé en temps

partagé ; il dispose d'éditeurs commodes, de possibilités de stockage et de communication entre utilisateurs. Il

était essentiel au projet archivage numérique, mais aussi aux autres activités de traitement du son, de le doter de

conversion en ligne -- un système « hors ligne » (off line) aurait considérablement diminué la commodité d'utilisation.

Le matériel informatique dont nous disposions au départ était le suivant :

Il faut noter que si cette capacité de disque est suffisante dans la plupart des applications, elle peut cependant être

insuffisante, non pas pour les études, mais pour l'exploitation de l'archivage numérique : cette limitation peut

être levée par le recours à des unités de disque de capacité plus importantes, qui existent sur le marché mais que

nous n'avons pas acquis pour des raisons d'économie (on notera que le prix des unités de disque de grande capacité

baisse rapidement). Par ailleurs, si l'on envisage l'exploitation extensive de l'archivage numérique, il est préférable

d'acquérir un dérouleur de bande magnétique plus rapide que le TU-10 afin d'effectuer plus rapidement le transfert

disque-bande. On pourrait alors envisager un transfert direct sur la bande : il faut noter cependant que le disque

permet un accès beaucoup plus rapide et commode si l'on veut effectuer des traitements sur le son mis sous forme

numérique.

Les programmes de transfert des échantillons ont été écrits d'abord par James Lawson, puis par Jean-Louis Richer,

avec la collaboration des responsables du moniteur du système DEC 10, Brian Harvey puis Raymond Bara. Ces

programmes devaient assurer le transfert mémoire de

Peter Eastty a conçu et presque entièrement réalisé pour le DEC 10, un accès direct mémoire (DMA) qui remplacera

le bus d'entrée/sortie programmé pour le transfert des échantillons : ce matériel permettra de décharger

complètement l'unité centrale lors des opérations de transfert ; ainsi les autres utilisateurs du DEC 10 (il y a

parfois plus de 20 utilisateurs simultanés) ne seront absolument pas pénalisés par l'enregistrement ou la restitution de

sons numérisés.

Il faut mentionner aussi l'adaptation et le développement par James Lawson d'un logiciel d'indexation automatique,

DART, permettant de retrouver les fichiers (en particulier les fichiers son) qui ont été archivés sous forme de bande

magnétique : si l'on tape « LOCATE » suivi du nom du fichier recherché, le programme donne la liste des

numéros des bandes sur lesquelles le fichier est archivé, ainsi que les dates d'archivage. (Notre version du

programme a été demandée par des centres étrangers utilisant le DEC 10).

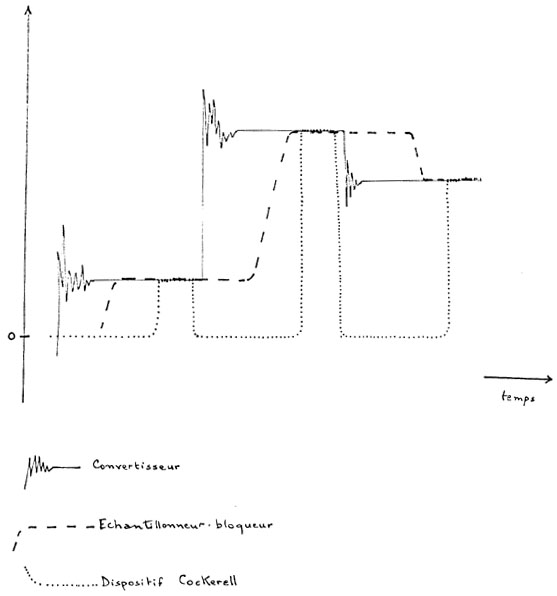

La solution proposée par David Cockerell tranche le noeud gordien en supprimant purement et simplement

l'échantillonneur et son ampli opérationnel (cf. Fig. 3) : le convertisseur est ouvert un temps bref pour « injecter »

sa valeur à la sortie, et le reste du temps la sortie est remise à zéro (ce qui est plus facile, par remise à la terre, que

d'essayer de réinjecter une valeur qui vient d'être donnée : il n'y a plus qu'un interrupteur qui ouvre ou ferme le

convertisseur). La sortie du convertisseur est donc envoyée directement dans le filtre. Il faut bien sûr un ampli

opérationnel pour intégrer ce signal, mais l'ampli sera placé après les filtres passe-bas, à un moment où la rapidité des

changements est fortement limitée -- aussi peut-on choisir un ampli pas très rapide mais d'excellente qualité (en

l'occurrence un ampli Neve d'une dynamique supérieure à 100 dB). Le procédé peut donner lieu à une distorsion

harmonique, bien moins gênante que la distorsion d'intermodulation de la technique classique.

Ce procédé ingénieux fonctionne très bien : Cockerell a obtenu des produits de distorsion d'intermodulation à

moins de 90 dB en-dessous du signal. La tension obtenue à la sortie est moins élevée que dans le procédé normal

(elle est multipliée par le quotient du temps d'ouverture du convertisseur au temps total), mais cela peut ne pas être

gênant si l'on est très attentif à ne pas introduire de bruits parasites. Deux convertisseurs 16 bits fonctionnant

suivant ce principe ont été opérationnels en février 1977 (à temps pour la conversion d'

« Inharmonique », de

J.C. Risset, la

première composition réalisée sur l'ordinateur de l'IRCAM et présentée en avril 1977 dans le cadre de la série IRCAM

« Passage du XXe Siècle »)

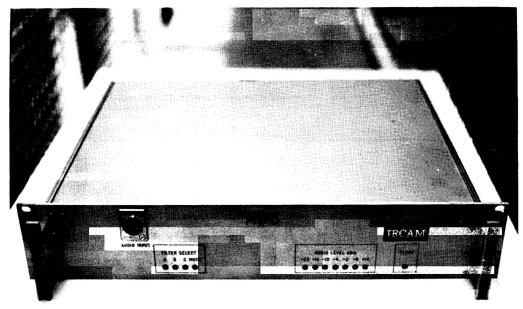

Moorer a donc défini le cahier des charges d'un dispositif de conversion comportant, comme il a été dit, un

convertisseur 16 bits avec le schème de Cockerell pour éliminer l'échantillonneur-bloqueur ; des isolateurs

optiques ; des alimentations isolées ; une double boîte métallique s'adaptant aux racks 19 pouces ;

une sortie symétrique ; et de plus un choix de filtres passe-bas commutables par ordinateur ou à la main (choix

recommandés initialement : 5 KHz, 10 KHz, 20 KHz), et un affichage à diodes électroluminescents indiquant le

choix du filtre et la valeur des 16 bits (représentés à volonté soit tels quels, soit convertis en dB -- chaque diode

correspond alors à un saut de 6 dB). L'horloge externe -- à quartz -- est reliée au dispositif par un câble blindé vidéo

séparé des lignes de données. La réalisation de convertisseurs suivant ces standards a été sous-traitée à Tim Orr,

Design Consultant, qui avait déjà l'expérience de ces problèmes de grande dynamique en conversion ; Tim Orr

a ainsi réalisé pour les besoins de l'IRCAM 8 convertisseurs d'entrée, 10 convertisseurs de sortie (1), munis de filtres

passe-bas (commutables par logiciel) à 4 KHz, 12,8 KHz et 18 KHz. Ces convertisseurs ont été livrés à l'IRCAM en 1978 et 1979, et la performance mesurée

(entre entrée analogique et sortie analogique après passage dans le domaine numérique) correspond à un rapport

signal sur bruit supérieur à 90 dB (cette valeur a été mesurée au distorsiomètre pour un taux d'échantillonnage de 50 KHz

avec un filtre passe-bas à 18 KHz). La diaphonie n'est introduite que par le système audio. Les produits de

distorsion du système d'enregistrement numérique sont inférieurs aux bruits résiduels, comme le souffle du préampli

du microphone, ou le ronflement dû au secteur. Par comparaison, un magnétophone analogique donne dans les

meilleures conditions un rapport signal sur bruit de 60 ou 65 dB ; les réducteurs de bruit du type Dolby ou DBX

permettent de gagner 10 ou 15 dB -- mais on gagne le même rapport en les utilisant avec l'enregistrement

numérique ; et il est difficile de se débarasser de l'importante distorsion d'harmonique 3 dans l'enregistrement

magnétique analogique (typiquement de l'ordre de - 35 dB).

Ces convertisseurs, fabriqués par Tim Orr sous licence IRCAM (Cf. Fig. 4), sont disponibles mondialement pour

l'usage haute fidélité -- archivage numérique et traitement des sons par ordinateur.

L'enregistrement numérique protège contre les erreurs : mais il ne faut pas se dissimuler cependant que les

erreurs, si elles surviennent, peuvent être graves, voire fatales. Les « drop-out » (pertes de niveau d'enregistrement dues

aux irrégularités de la couche d'oxyde magnétique), causes de distorsion dans l'enregistrement analogique, peuvent

créer une perte momentanée du signal dans l'enregistrement numérique. Et il importe que les têtes de lecture des

disques et dérouleurs de bande soient soigneusement alignées, faute de quoi il peut être impossible de relire un

enregistrement : mais moyennant ces précautions, l'enregistrement utilisant les mémoires de masse d'un

système informatique est d'une grande sécurité. Les systèmes commerciaux utilisent des magnétophones vidéo qui

sont sujets à erreurs non récupérables et qui peuvent s'accumuler (cf. ci-dessous, III).

Le système développé à l'IRCAM permet l'archivage numérique et a été utilisé occasionnellement à ce titre. C'est ainsi

qu'ont été archivés des enregistrements instrumentaux réalisés par David Wessel et Ben Bernfeld, enregistrements

qui ont été soumis à des analyses ou des traitements « microchirurgicaux » par ordinateur, en particulier pour les

recherches de Moorer, Wessel, Rodet, Di Giugno, Asta, et les pièces Arcus

de York Höller et Mirages de

Jean-Claude Risset, présentées en 1978 dans l'Espace de Projection de l'IRCAM, et qui utilisent des sons instrumentaux

enregistrés et restitués avec ou sans modification par l'ordinateur. Preuve est donc faite que ce système peut servir à

l'archivage numérique des sons, et l'IRCAM a eu des demandes pour l'utiliser dans ce sens (2). Il faut bien voir

cependant que sous sa forme actuelle le système n'est pas optimisé pour une exploitation intensive -- qui ne

correspondrait d'ailleurs pas à la mission de l'IRCAM. Jusqu'à l'achèvement (imminent) du DMA, les conversions

pénalisent substantiellement les autres utilisateurs de l'ordinateur. Si on devait faire une utilisation importante de

l'archivage numérique à l'IRCAM, il faudrait envisager l'acquisition d'un dérouleur rapide avec enregistrement à haute

densité, ce qui résoudrait les problèmes de la capacité limitée des disques et du temps de transfert disque-bande. Il

serait par ailleurs utile de bénéficier de schèmes de réduction de données pour réduire les dimensions des archives à

constituer : c'est le sujet du prochain chapitre de ce rapport.

Mathews a également proposé un système élaboré tirant parti d'une compression-expansion, basée sur un

amplificateur à commande exponentielle par tension d'entrée et une détection d'amplitude, comme celle qui est

assurée dans le dispositif réducteur de bruit DBX. Si l'on veut non seulement enregistrer mais transformer ou

synthétiser des sons dans le domaine numérique, il importe de savoir réaliser numériquement le même codage et

décodage que dans le domaine analogique -- or les caractéristiques du codage, en particulier les constantes de

temps pour l'évaluation des amplitudes, n'étaient pas explicitées complètement par le constructeur. James Lawson

avait effectué sur cette idée des essais prometteurs mais non encore concluants.

Mathews et Lawson ont également effectué quelques essais sur un schème de réduction de données par modulation

adaptive (on code la différence entre 2 échantillons successifs, d'une manière variant avec le signal).

Ces études ont été arrêtées au moment de la réalisation de la conversion suivant le procédé Cockerell -- mais

les idées qu'elles ont fait surgir peuvent trouver une application ultérieure. Moorer a repris l'étude des économies de

codage.

Moorer a d'abord étudié les codes de Huffman (codes de longueur minimale). Les codes de Huffman permettent de

condenser l'information apportée par les valeurs des échantillons en tablant sur le fait que ces valeurs ne sont pas

équiprobables : ils attribuent aux valeurs les plus fréquentes des codes plus courts. Ce codage utilise donc un

histogramme des valeurs des échantillons : ceci impose d'effectuer deux passages (un pour évaluer

l'histogramme, un autre pour recoder les échantillons). Cette nécessité interdit l'enregistrement direct sous forme

codée réduite -- pour cela, il faut utiliser une statistique accumulée a priori sur un corpus de matériaux sonores

représentatifs : mais si la statistique n'est pas représentative du matériau enregistré, le codage peut dilater --

parfois considérablement -- l'information au lieu de la condenser.

Moorer a proposé des schèmes modifiant les codes de Huffman et tirant parti des spécificités de l'application

audio : ses schèmes limitent l'explosion d'information si le code prend plus de place que l'échantillon

original ; d'autre part Moorer a comparé du point de vue de l'économie le codage de l'échantillon lui-même, de la différence entre deux échantillons successifs,

(modulation

, soit X(n) - X(n-1)) et de la différence seconde (X(n) - 2X(n-l)+X(n-2)) en partant de l'idée que

l'énergie sonore est en général plus forte dans les basses fréquences, et que les différences ont donc des valeurs plus

petites que les échantillons eux-mêmes. Enfin les schèmes de Moorer limitent le codage aux bits de poids fort,

l'entropie des bits de poids faible étant trop élevée. Moorer a étudié expérimentalement ces schèmes en les appliquant

à divers signaux sonores (parole, musique instrumentale enregistrée, musique synthétique). L'expérience a montré

qu'il était inutile de recoder le bit de signe et les 3 derniers bits de poids faible ; qu'on gagnait à coder les

différences secondes, même pour les sons riches en haute fréquence ; et que l'utilisation pour un matériau d'un

codage non défini à partir de l'histogramme de ce matériau pouvait parfois dilater beaucoup l'information. Autre

problème : le codage (et le décodage) se faisant bit par bit, et chaque échantillon comportant un nombre

variable de bits, il devient impossible de décoder si l'on ne commence pas du début ou s'il y a une erreur. Pour pallier

cet inconvénient, il faut grouper les échantillons en blocs (inégaux) au début desquels on réinitialise le code. Malgré

ces problèmes, le codage peut être utile : la réduction d'information sans distorsion atteint de 5 à 7 bits pour des

échantillons de 16 bits.

La forme du codage minimal a suggéré à Moorer d'étudier un codage original : codage « incrémental à virgule

flottante ». Le codage mis au point par Moorer peut être considéré à la fois comme une extension d'un simple codage à

virgule flottante (représentation par mantisse et exposant) et comme une simplification du codage par prédiction

linéaire ; il coïncide également, pour certaines valeurs des paramètres avec un schème décrit par Samson

(1978). Un arrondi préalable est effectué et un processus spécial permet d'économiser un bit sur le signe. Le

processus peut être mis en oeuvre en utilisant des registres à décalage sans multiplication. Le codage a été simulé

sur l'ordinateur PDP 10 afin de déterminer quel nombre de bits pour mantisse et exposant donnait lieu à la meilleure

réduction de données en introduisant le moins de perturbation -- cela en préservant une dynamique correspondant à

16 bits linéaires. (Cette valeur de 16 bits, linéaire en M.I.C., (P.C.M.), d'après les essais réalisés à l'IRCAM et ailleurs,

paraît correspondre à des spécifications satisfaisantes pour l'enregistrement des signaux musicaux, à condition que la

dynamique ne soit pas réduite par des effets parasites introduisant un bruit ou des produits de distorsion plus

importants qu'ils ne devraient être -- Cf. ci-dessus, I.4 ; on a des indications que les 14 bits utilisés par la

B.B.C. -- pour la transmission entre Londres et l'Ecosse de programmes radio à dynamique comprimée (B.B.C.,

1967 ; Croll et al, 1973) -- ne sont pas suffisants dans tous les cas).

Pour des sinusoïdes dont la fréquence est basse par rapport au taux d'échantillonnage, le schème proposé donne

bien une meilleure approximation qu'un simple codage à virgule flottante de même longueur, mais il est un peu moins

précis aux fréquences élevées ; une évaluation significative de son utilité nécessite une étude psychoacoustique

comportant des tests perceptifs. Les sinusoïdes de fréquence moyenne (voisines de 1.000 Hz)

masquent les bruits de quantification mieux que celles de fréquences-extrêmes, et la grande

audibilité des distorsions dans les fréquences graves fait que le codage proposé est bien supérieur au simple codage

en virgule flottante. Les tests subjectifs, effectués dans les conditions les plus sévères (sur des sinusoïdes), ont

montré qu'il suffisait de représenter la mantisse avec une précision de 9 bits, voire de 8 bits (l'exposant occupant 4

bits) pour que le signal codé ne puisse être distingué de l'original (16 bits) : la réduction apportée est de 20 à

30% et il faut voir qu'on a ainsi une dynamique correspondant à celle donnée par un codage entier (non flottant) sur 24

bits !

Le codage incrémental à virgule flottante proposé par Moorer est utile et facile à réaliser ; il peut être préférable

de l'éviter si l'on doit effectuer ultérieurement des traitements -- analyse, filtrage -- sur le signal :

mais ce codage se prête parfaitement à l'archivage numérique, sur lequel il permet une réduction de données

atteignant 30% sans perte de qualité.

En ce qui concerne la place de l'enregistrement numérique dans l'industrie de l'enregistrement, il nous faut distinguer

le cas de l'utilisateur professionnel (radios, studios d'enregistrement) de celui de l'utilisateur privé, de l'amateur de

haute fidélité : les budgets possibles et les difficultés d'emploi acceptables ne sont à la même échelle pour ces

deux catégories d'utilisateurs.

L'enregistrement numérique est une réalité : il est utilisé à l'IRCAM, où dans le cadre de cette étude nous avons

développé un système expérimental d'enregistrement à hautes performances à partir d'un système informatique

puissant de traitement des sons ; il est utilisé dans d'autres centres de recherche (Stanford University, Bell

Laboratories, Carnegie-Mellon University, University of Utah, B.B.C. Research Center, Centre National d'Etudes des

Télécommunications) ; il est utilisé aussi dans les milieux professionnels de l'enregistrement, qui ont recours

parfois à l'enregistrement numérique en vue de la réalisation de disques commerciaux. De telles institutions peuvent

se permettre des investissements élevés pour développer des outils raffinés pour la recherche, ou pour tenter

d'économiser sur les sessions coûteuses d'enregistrement. A l'IRCAM l'enregistrement numérique utilise un système

informatique qui était de toute façon nécessaire aux recherches (en particulier sur

le traitement des sons) réalisés à l'Institut : cela procure la possibilité de traitements raffinés

sur les enregistrements, et assure la sécurité liée aux vérifications du type contrôle de parité. Mais il faut voir que ces

traitements peuvent pour l'instant difficilement être réalisés en temps réel comme ils le sont dans un studio

d'enregistrement ; d'autre part l'archivage sur des bandes enregistrées à une densité de 800 caractères par

pouce (en abrégé bpi, comme bits per inch) est très encombrant (bien plus que les bandes analogiques). Il est vrai

que la densité utilisable s'accroît, mais les erreurs deviennent aussi plus difficiles à éviter ; le maximum

actuellement utilisé en informatique est de 6400 bpi. Comme il a été dit, le système expérimental d'enregistrement

numérique de l'IRCAM pourrait être utilisé de façon extensive, pour réaliser des archives sonores, une fois l'accès

direct-mémoire terminé (ce qui sera le cas incessamment), et moyennant l'addition d'un dérouleur de bande

magnétique rapide. Il est clair que les magnétophones analogiques seront encore utilisés de longues années pour

l'usage courant, en raison de leur coût moins élevé, de leur portabilité et de leur maniabilité.

Les systèmes commerciaux tendent à utiliser des magnétophones vidéo modifiés, moins coûteux, et sur lesquels on

peut obtenir des densités jusqu'à 28000 bpi -- mais au prix d'une fiabilité bien moins grande. Ainsi le système

pionnier de Stockham utilise une méthode d'enregistrement (Cf. Warnock, 1976) qui permet de condenser les

informations au point que les bandes d'enregistrement numérique ne prennent pas beaucoup plus de place que des

bandes analogiques. Mais ces magnétophones donnent des erreurs -- et les bandes devraient être recopiées

périodiquement (chaque année au moins ?) pour éviter l'accumulation de ces erreurs, qui nuisent à la qualité du

son. On notera que Stockham a commercialisé (en location) son système d'enregistrement numérique (Soudstream,

inc.) qui a été utilisé pour réaliser des bandes-mères (« masters ») de disques -- en particulier l'équipe de

Stockham a pu « rafraîchir » par traitement sur ordinateur certains enregistrements de Caruso (Cf. Ingebretsen, 1978).

Parmi les autres systèmes commerciaux, on peut citer celui de Three Rivers Corp. (Kriz) ; de 3M ; de

Denon, utilisé pour les « masters » des disques Nippon-Columbia (ce système utilise une fréquence d'échantillonnage

de 47,25 KHz, et 13 bits pour décrire les échantillons plus 2 bits pour la correction d'erreur. L'enregistrement se fait en

8 pistes. Les 5,67 Mégabits par seconde sont enregistrés sur un magnétophone vidéo à 4 têtes (vitesse 38 cm/s,

largeur de la bande 50 mm) ; de Matsushita et de Sony, qui utilisent un enregistreur vidéo à cassette. (Le

système Sony, dit Betamax, utilise 14 bits en stéréo ; il n'est pas très coûteux, mais ses caractéristiques ne sont

pas les meilleures qu'on puisse atteindre -- il vise déjà la clientèle privée).

Le problème des erreurs reste très gênant. Il existe des schèmes de codage redondants qui permettent de corriger les

erreurs ; il y a aussi des techniques pour réduire la nuisance des erreurs : par exemple on peut alterner

les échantillons -- échantillons pairs dans un bloc, échantillons impairs dans un autre bloc si l'on perd un bloc,

on ne fait que diviser par deux le taux d'échantillonnage sur la fraction de seconde correspondante et on peut

interpoler entre les échantillons conservés. Un tel schème est utile, surtout si l'on utilise un codage à haute

densité : si un fragment du support est défectueux (drop-out sur une bande) il pourra introduire des erreurs sur

de nombreux bits consécutifs.

Il serait évidemment intéressant de disposer dans les studios non seulement d'un magnétophone numérique, mais de

consoles numériques de mixage remplaçant les consoles analogiques actuelles. Les compagnies d'enregistrement

réalisent en effet le plus souvent des enregistrements multi-pistes suivis de mixages. La multiplication des pistes

complique le problème pour l'enregistrement numérique en raison de la grande capacité de débit d'information qu'elle

exige. Mentionnons cependant que plusieurs firmes (Ampex, 3M) étudient des enregistrements numériques

multi-pistes, ainsi la Société 3M réalise-t-elle pour deux compagnies d'enregistrement un enregistrement numérique

codant 32 canaux avec une résolution de 16 bits sur une bande de 1 pouce : une bobine de 14 pouces de

diamètre peut enregistrer plus de 30 mn de son ; le taux d'échantillonnage est de 50.000 Hz. Les performances

nominales sont excellentes, mais on ne dispose pas d'analyse de la performance en fonction des erreurs de lecture de

la bande. Le coût est de l'ordre de $ 150.000.

Par ailleurs les consoles analogiques ont atteint un haut niveau de qualité (rapport signal sur bruit de l'ordre de 110 dB)

et de commodité cependant la difficulté de réalisation des mixages conduit à développer des consoles

automatisables, pouvant mémoriser les paramètres d'un mixage réalisé manuellement. Précisons pour éviter les

confusions que les tables de mixage automatisées disponibles actuellement (par exemple Compumix, Neve Necam,

MCI JH-500, Automated Processes, Allison Memory Plus) sont des consoles analogiques à commande numérique

(utilisant un amplificateur commandé par tension d'entrée). Les consoles numériques paraissent très attrayantes par

les commodités de mémorisation et de traitements précis du son qu'elles pourraient offrir. (C'est ainsi que nous

disposons à l'IRCAM d'un ensemble de programmes de microchirurgie du son très raffinés, disponibles sur l'ordinateur

DEC 10 (Rolnick, 1979) et applicables donc à tout enregistrement numérique réalisé suivant le format 16 bits linéaire).

Toutefois on ne saurait pas actuellement coder les sons avec une précision assurant le rapport signal sur bruit de 110

dB qu'on sait réaliser dans les consoles analogiques ; et certaines opérations (filtrage) sont moins faciles à

réaliser numériquement qu'analogiquement. La BBC s'est attaquée au problème des consoles numériques en

construisant le prototype (COPAS) d'un processeur numérique spécialisé pour le traitement numérique des signaux

audio (Mc Nally) ; ce système à 2 entrées et jusqu'à 16 sorties comporte un microprocesseur et un processus

rapide microprogrammable ; il peut effectuer les opérations typiques des consoles de studio (mixage,

égalisation, compression) ainsi que divers traitements (analyse spectrale, réverbération, vocoder, synthétiseur). Il est

vraisemblable que ce type de consoles va se multiplier : toutefois la conception de telles consoles est délicate,

et il est difficile de prévoir à quels moments leurs avantages l'emporteront sur leurs inconvénients. Après la phase de

conception, le facteur économique devrait tourner rapidement à l'avantage des consoles numériques.

Malgré les apparences, le facteur économique n'est pas non plus un obstacle définitif à la distribution

d'enregistrements numériques à la clientèle privée. Des réalisations comme le système Betamax de Sony, utilisant un

magnétophone vidéo, sont encore coûteuses mais non plus inabordables pour l'utilisateur individuel. L'utilisation des

disques vidéo est prometteuse dans ce sens : plusieurs organisations (Philip-Magnavox ; JVC-Nivico,

branche de Matsushita, Mitsubishi-Teac ; Pioneer ; RCA ; Battelle Institute) ont développé des

prototypes d'enregistreurs et de lecteurs numériques sur disque, l'enregistrement et la lecture faisant souvent appel à

un laser : ce processus pourrait, semble-t-il, être commercialisé pour un prix pas trop élevé

(le système Philips, très compact -- un disque de 115 mm de diamètre -- est même prévu pour l'usage dans les

voitures !).

Cependant pour que cette possibilité soit intéressante, il faut qu'il existe sur le marché des enregistrements numériques

qui puissent être lus sur des lecteurs numériques disponibles : si les normes d'enregistrement ne sont pas

compatibles avec celles des lecteurs, l'utilisation de l'enregistrement est impossible. Aussi doit être résolu un problème de

normalisation beaucoup plus aigu que celui qui se posait pour l'enregistrement analogique. Il faut normaliser les

caractéristiques d'enregistrement numérique : taux d'échantillonnage (actuellement le taux utilisé varie entre 32 et

50 KHz) nombre de bits (de 12 à 16 bits) ; loi de codage (linéaire, logarithmique, etc. cf. II.2) ; protection

contre les erreurs -- et également, par exemple, les dimensions physiques des enregistrements (Sony et Philips

proposent respectivement des disques de diamètre 12 pouces et 4 pouces 1/2)... Fin 1977, l'Audio Engineering Society

(3) a formé un comité de standards audio numérique (Mc Knight, 1978) : ce comité recommande une précision de 16

bits et un taux d'échantillonnage de 50 KHz -- ou de 44,056 KHz, bien adapté à l'usage des magnétophones

vidéo -- (Sony annonce un processeur pour la conversion entre ces deux taux d'échantillonnage).

En raison des problèmes de normalisation et de constitution d'un répertoire et vu les coûts encore élevés, il se passera

certainement plusieurs années avant que les systèmes numériques soient commercialisés pour la clientèle privée

-- et ce seront au départ des appareils haut de gamme --. Déjà utilisé dans les studios d'enregistrement, le

numérique va sans doute voir son intervention s'étendre, en raison de ses coûts décroissants (4), de la qualité qu'il

autorise, des possibilités de manipulation commode qu'il permet de mettre en oeuvre. On ne peut dire dans quel délai de

nouveaux types de stockage (hologrammes, mémoire à bulle) pourront prendre le relais de l'enregistrement magnétique

comme support des enregistrements numériques il serait également aventureux de prédire à quelles réalisations pratiques

pourront aboutir les idées du haut-parleur et du microphone numérique. En tout cas, grâce à l'enregistrement numérique,

on peut unifier le format du répertoire enregistré et celui de la synthèse et du traitement des sons par ordinateur, ce qui

pourrait déboucher sur des possiblités nouvelles de jeu musical : c'est important pour un Institut de recherches

musicales, mais ce peut l'être aussi pour l'utilisateur privé, en réservant une place à la créativité individuelle.

Dans le cadre du projet « Archivage numérique des sons », l'IRCAM a construit un système expérimental

d'enregistrement numérique faisant appel à un processus de conversion nouveau et incorporant des précautions

assurant de hautes performances : les convertisseurs sont disponibles commercialement sous licence IRCAM,

et ils permettent de réaliser un archivage fiable des sons, bien que le système IRCAM dans son état actuel soit mal

adapté à une utilisation extensive de ces possibilités d'archivage. Par ailleurs une étude sur les principes de codage a

conduit à définir une méthode aboutissant à une réduction de données de l'ordre de 30% sans perte de qualité.

____________________________ ____________________________I. Mise en oeuvre d'un système d'enregistrement numérique des sons à l'Ircam

I.1 Rappel du principe de l'enregistrement-numerique des sons

Le premier système d'enregistrement numérique des sons a été réalisé en 1958 par David, Mathews et Mc Donald aux

Bell Laboratories. Les principaux problèmes du procédé sont exposés dans les références suivantes : David,

Mathews et Mc Donald (1959) ; Mathews (1969) ; Stockham (1971). Les sons sont échantillonnés,

c'est-à-dire que leur amplitude est mesurée à des intervalles de temps très rapprochés ; les échantillons

successifs (les valeurs successives des amplitudes) sont codés sous forme binaire. Ce codage numérique, proposé

par Reeves dès 1939, et appelé M.I.C. (Modulation par Impulsions Codées) -- en anglais P.C.M. (Pulse Code

Modulation) permet de protéger l'enregistrement contre le bruit : il suffit que le codage assure que la différence

entre les valeurs correspondant aux 0 et 1 de chaque élément binaire (ou bit) émerge du bruit du canal physique.

I.2 Mise en oeuvre du transfert des échantillons à l'IRCAM

Nous réservons pour le paragraphe suivant l'examen de l'étape cruciale, celle de la conversion analogique-numérique

et numérique-analogique, sur laquelle ont surtout porté nos efforts. Dans ce paragraphe nous expliquons comment la

conversion a été mise en oeuvre « en ligne » (on-line) sur l'ordinateur central de l'IRCAM, un système DEC 10.

L'unité de disque unique devait recevoir les fichiers de tous les utilisateurs en plus des fichiers sons : sa

capacité de 10 Méga mots était tout-à-fait insuffisante pour permettre un enregistrement extensif de sons en plus du

stockage des programmes système et des fichiers utilisateurs. Aussi nous sommes-nous équipés pour le projet de

deux unités de disques supplémentaires dont l'une, DSKM (M comme Musique), était une unité « banalisée » réservée

aux fichiers de sons sous forme numérique, l'autre, DSKS, étant affectée aux sessions spéciales d'enregistrement et

au système. La capacité d'une unité de disque (10 Méga mots de 36 bits) assurait la possibilité d'enregistrer cinq

minutes de son stéréo enregistré à un taux d'échantillonnage de 50.000 avec une précision de 12 bits. Pour

l'archivage, les échantillons peuvent être transférés du disque à une unité de bande TU-10 lente -- ce transfert n'est

pas fait en temps réel : le transfert de 10 mn de son du disque à la bande peut demander 25 mn.

I.3 Premier système de conversion

La conversion a d'abord été réalisée avec une précision provisoire de 12 bits, suivant un schéma conçu par Joseph

Zingheim et déjà mis en oeuvre à Colgate University. Quoique satisfaisant dans beaucoup de cas, la précision de 12

bits était insuffisante dans certaines situations, et en particulier pour assurer un enregistrement de haute qualité. Par

ailleurs le schéma de Zingheim présentait certains problèmes spécifiques. Toutefois la mise en oeuvre de cette

conversion 12 bits nous a permis de travailler avant la mise au point des convertisseurs finaux et de résoudre les

problèmes d'interface (matériel et logiciel) avec l'ordinateur. La conversion 12 bits a été opérationnelle en mai 1976

-- elle a été en usage même après la mise en place des convertisseurs 16 bits : dans les cas où la qualité

n'était pas critique, l'économie de stockage présentait un intérêt.

I.4 Un nouveau principe de conversion (Cockerell) et sa mise en oeuvre

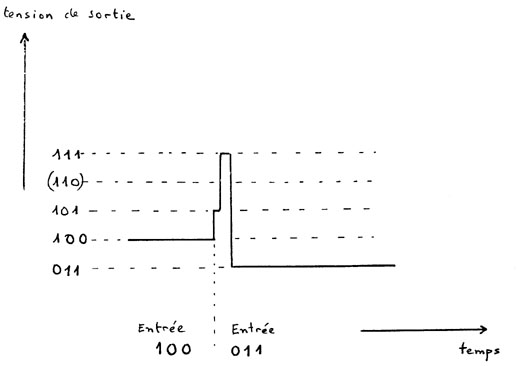

Comme il a été mentionné ci-dessus (I.1), la conversion rapide et à haute précision soulève des difficultés. En effet la

commutation des divers bits du convertisseur entre un échantillon et le suivant n'est pas rigoureusement synchrone,

ce qui crée des transitoires gênants (« glitches ») qui peuvent donner lieu à des distorsions inacceptables. (Ainsi dans le

passage de l'échantillon 100 à 001, si le bit de poids fort bascule moins vite, on passera par la valeur 111 -- Cf. Fig. 2 --).

On remédie d'habitude à ce problème en utilisant un échantillonneur-bloqueur (sample and hold) qui maintient la sortie à la valeur précédente jusqu'à ce que

la commutation de tous les bits soit effectuée : à ce moment, la valeur de sortie devient la nouvelle valeur

affichée. Toutefois l'échantillonneur-bloqueur peut créer une distorsion importante : en effet le passage d'une

valeur à la suivante ne peut se faire instantanément en raison de l'inertie des amplis opérationnels, aussi y a-t-il une

erreur dans la sortie, erreur qui est proportionnelle au carré de l'amplitude de la transition. Il faut typiquement

pour une transition d'un bout à l'autre de l'échelle : si une sinusoïde de fréquence 7 KHz et

d'amplitude maximum est échantillonnée à 20 KHz, la sinusoïde est échantillonnée environ trois fois par cycle, et les

différences dues au temps de transfert se répéteront tous les sept cycles ; ainsi sera produite par hétérodynage

une composante de 1 KHz d'une amplitude de -- 35 dB environ (Kriz 1975 ; Talambiras 1976). Aussi Kriz a-t-il

conçu un échantillonneur-bloqueur d'un type différent, et qui joue un grand rôle dans la qualité du système de

conversion qu'il a mis en oeuvre à Carnegie-Mellon University. Mais ce dispositif est coûteux et délicat. D'autre part il y

a un autre problème que celui de la limitation du taux de montée (slew rate) de l'amplificateur opérationnel :

l'échantillonneur-bloqueur comporte en fait l'injection de la nouvelle valeur et un dispositif de bouclage pour maintenir

l'ancienne valeur : ces deux opérations sont commutées par un transistor FET : si la synchronisation n'est

pas très exacte, des parasites apparaissent -- il faut réaliser la synchronisation à mieux de 5 nanosecondes près pour

assurer un rapport signal sur bruit d'environ 90 dB.

I.5 Définition et réalisation d'un système de conversion suivant les spécifications IRCAM

Les essais convaincants de Cockerell ont posé la question du brevet. Le procédé ne semble pas brevetable, car ce

type d'échantillonnage intermittent avec remise à zéro est utilisé dans d'autres contextes -- mais des contextes de

fonctionnement très lent et non pas de grande vitesse ! De plus les difficultés posées par la prise de brevets

américains, les plus importants dans ce domaine tant la conversion est étudiée aux Etats-Unis, et la multiplicité des

brevets nécessaires à l'époque pour couvrir l'Europe, ne nous ont pas incités à entreprendre une demande de brevet

au résultat douteux. Cependant Andy Moorer a suggéré de compléter la conversion suivant le procédé Cockerell en

veillant particulièrement à éviter les bruits parasites, afin de réaliser un boîtier de conversion fiable, d'usage général et

susceptible de commercialisation sous licence IRCAM. Andy Moorer a ainsi ajouté des isolateurs optiques, pour éviter

la fuite du bruit radioélectrique de l'ordinateur vers la sortie des convertisseurs il a isolé les alimentations :

chaque convertisseur possède cinq alimentations différentes isolées ; enfin il a utilisé un ampli de ligne Neve

pour assurer une sortie symétrique flottante ; de cette façon il est possible d'alimenter plusieurs entrées de

haute impédance. Moorer a recommandé d'inclure chaque unité de conversion dans une boîte métallique et de mettre

la partie audio associée dans une autre boîte métallique, pour éviter la diaphonie électromagnétique par ondes courtes

entre numérique et audio.

I.6 Mise à l'essai de l'enregistrement numérique

Il avait été prévu initialement de procéder à des essais comparés sur les défauts des enregistrements analogiques et

numériques et particulièrement sur leur tolérance aux mauvais traitements et aux détériorations du support physique.

Ces essais ont été très brefs, en effet l'enregistrement numérique permet d'éviter le souffle, le pleurage, le

scintillement, la diaphonie, le préécho (parfois appelé effet de copie), la détérioration à chaque génération de copie, et

il est patent que les enregistrements analogiques se détériorent beaucoup plus que les enregistrements numériques

en fonction de mauvais traitements (surtout champs magnétiques, dûs à des moteurs, haut-parleurs, transformateurs,

machines à écrire électriques, et même à des têtes de lecture légèrement magnétisées : ainsi l'usage normal

d'une bande analogique la détériore irréversiblement).

II. Recherche sur de nouveaux principes de codage

II.1 Examen préliminaire de nouvelles possibilités

Max Mathews a envisagé divers schèmes de conversion possibles, dont certains sont très différents du processus

classiquement utilisé : en particulier l'un d'eux utilise des oscillations très rapides et un processus d'interpolation pour

rejeter les erreurs hors de la bande de fréquence audio (Cf. Insam, 1973 ; Candy 1974). Ce schème est

prometteur pour la conversion analogique-numérique ; il permet de diminuer la gêne créée par le saut du signal

entre niveaux adjacents (le signal d'erreur correspondant est gênant car très riche en harmoniques). Mathews a étudié

la possibilité d'associer de façon additive (ou multiplicative) plusieurs convertisseurs 12 bits pour obtenir une précision

supérieure : chacun de ces convertisseurs serait affecté d'un poids différent, et l'ordinateur prendrait le signal du

convertisseur opérant dans la bonne région -- il enregistrerait aussi un code indiquant de quel convertisseur vient le

signal. Si les convertisseurs ne sont pas parfaitement alignés, la commutation peut introduire des perturbations, aussi

importe-t-il de ne pas commuter trop souvent. La caractéristique de codage obtenue par ce moyen donnerait des

niveaux fins plus serrés et des niveaux relevés plus espacés -- la séparation entre niveaux variant

de façon discontinue lorsqu'on passe d'un convertisseur à un autre.

II.2 Propositions pour des économies de codage (Moorer)

Divers schèmes mentionnés en II.1 s'écartent de la M.I.C. (ou P.C.M.) pour atteindre un ambitus dynamique plus

grand avec le même nombre de bits. Dans le cadre du projet de recherche sur l'archivage numérique des sons,

Moorer a effectué à l'IRCAM une étude sur la réduction d'information par recodage des échantillons, et sa validité

perceptive pour assurer une haute qualité sonore. Les résultats de cette étude, présentés à la 62e Convention de

l'Audio Engineering Society, sont décrits dans un article paru dans le Journal de l'Audio Engineering Society. Nous en

résumons ici les conclusions.

III. Possibilités, problèmes et perspectives de l'enregistrement numérique des sons.

Notre étude confirme que les techniques numériques permettent d'obtenir des

enregistrements de meilleure qualité, et mieux protégés contre la

détérioration, que les techniques analogiques. Il apparaît donc que ce sont les avantages économiques ou la

commodité des systèmes analogiques qui empêchent l'analogique d'être supplanté par le numérique. Qu'en est-il

actuellement dans le cadre de l'IRCAM et dans celui de l'industrie de l'enregistrement ? Quels développements

peut-on attendre dans les années à venir ?

Conclusion

Ce survol de l'enregistrement numérique aujourd'hui et demain montre l'importance de ce domaine : il était

important pour l'IRCAM d'y contribuer dès le début de son activité.

Figures et légendes

Figure 1

Schéma d'un convertisseur numérique-analogique 5 bits (d'après Mathews, 1969).

L'entrée numérique correspond aux commutateurs C0 à

C4. A est un ampli opérationnel servant à convertir le courant en tension.

E0 est la tension de sortie.

Figure 2

Formation d'un « glitch » lors du changement de valeur de l'entrée d'un convertisseur

3 bits. Si l'entrée passe de la valeur 100 à 011 et si les commutateurs correspondant aux bits de poids fort

basculent moins vite, la valeur de sortie passera transitoirement par les valeurs 101 et 111.

Figure 3

Comparaison des sorties du convertisseur seul (en traits continus), muni d'un

échantillonneur-bloqueur (en tirets), et muni du dispositif Cockerell (en pointillés). On remarquera

que le délai de réponse de l'échantillonneur-bloqueur dépend de l'amplitude de la transition.

Figure 4

Photo du premier convertisseur réalisé par Tim Orr suivant les spécifications IRCAM. (Le

convertisseur s'adapte aux racks standard de 18 pouces).

Références

Notes

Server © IRCAM-CGP, 1996-2008 - file updated on .

Serveur © IRCAM-CGP, 1996-2008 - document mis à jour le .